3月18日,理想汽車在NVIDIA GTC大會上發(fā)布下一代自動駕駛架構(gòu)MindVLA,還放話要像當(dāng)年iPhone 4重新定義手機那樣,重新定義自動駕駛。這不禁令人好奇,理想憑啥這么有底氣?它又會給整個行業(yè)帶來哪些改變呢?咱們一起探討一下。

從按部就班到自主思考

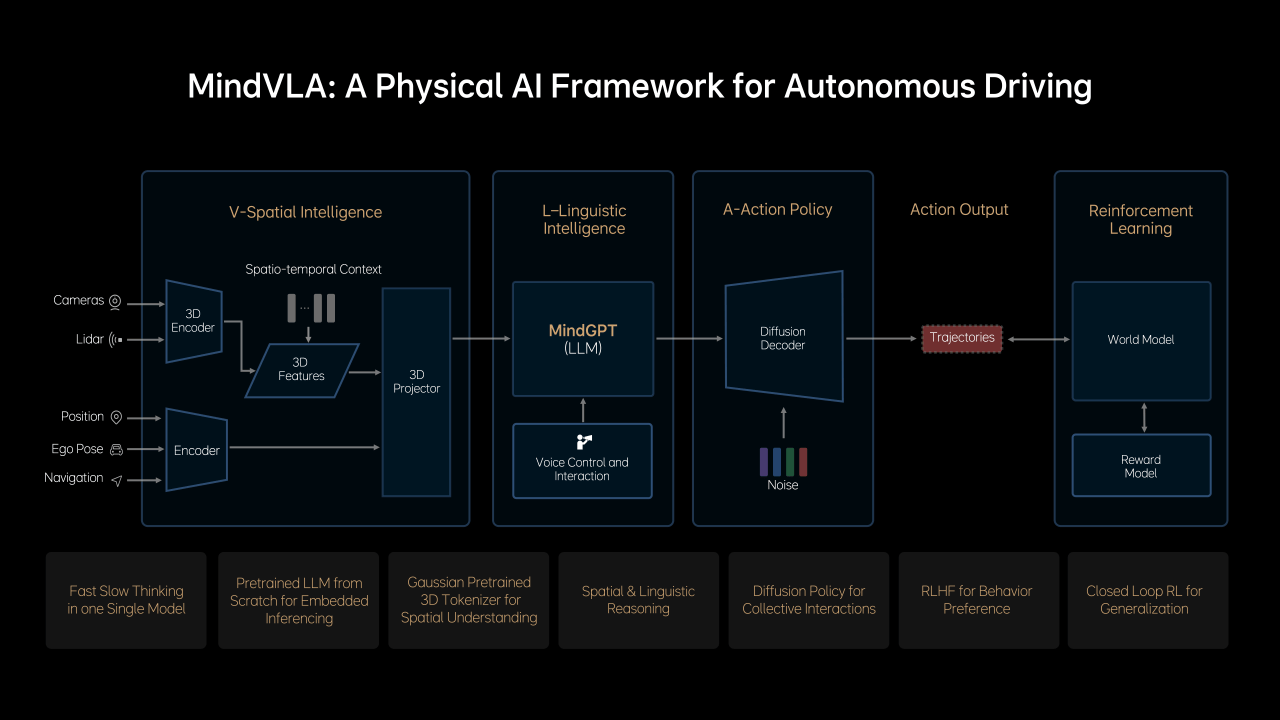

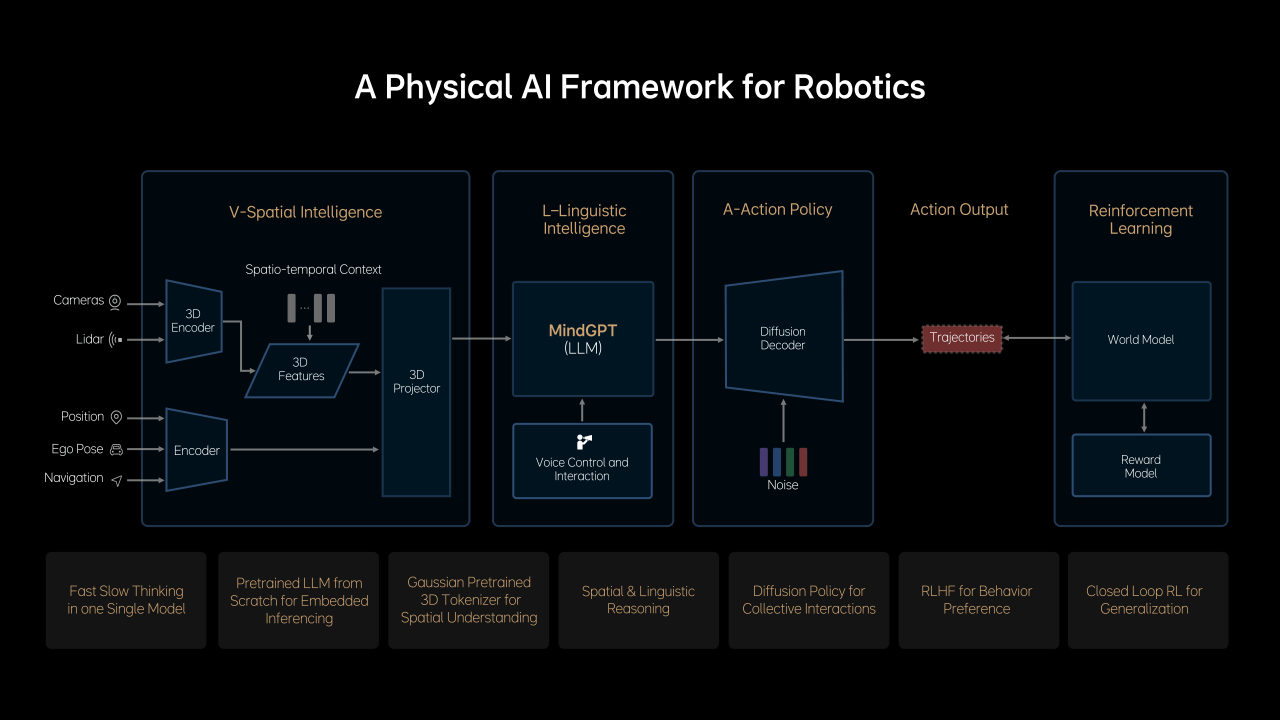

話說以前的自動駕駛,基本需要高精地圖與提前設(shè)好的規(guī)則來運行,就像個跟著劇本走的“演員”,靈活性差。但MindVLA的不同之處,在于它會給自己打造一套類似人類認(rèn)知邏輯的“大腦”,采用“端到端+VLM雙系統(tǒng)架構(gòu)”。

簡單來講,一個“快思考”系統(tǒng),也就是端到端大模型,能像我們的直覺一樣,對駕駛場景快速做出判斷與反應(yīng),馬上給出行駛軌跡;而另一個“慢思考”系統(tǒng),并不是想的慢的意思,而是視覺語言大模型,專門負(fù)責(zé)處理較復(fù)雜的邏輯問題,比如判斷公交車道的動態(tài)標(biāo)記、車道信號燈等復(fù)雜情況。

有個實際例子,在測試視頻里,車沒預(yù)設(shè)導(dǎo)航路線,通過一句“幫我找個星巴克”,自己就找到路邊門店并穩(wěn)穩(wěn)停下來。若遇到死胡同,還能自動倒車,重新尋找車位,關(guān)鍵全程還不依賴地圖數(shù)據(jù),這出色的表現(xiàn),得益于3D高斯中間表征技術(shù),通過大量數(shù)據(jù)自我學(xué)習(xí),讓車對復(fù)雜情況理解更加到位,這有點像偏科生的味道,專注并理解透這門學(xué)科,與專科生不同,因為它更加全面。

讓用戶體驗升級,從機械式到更懂你

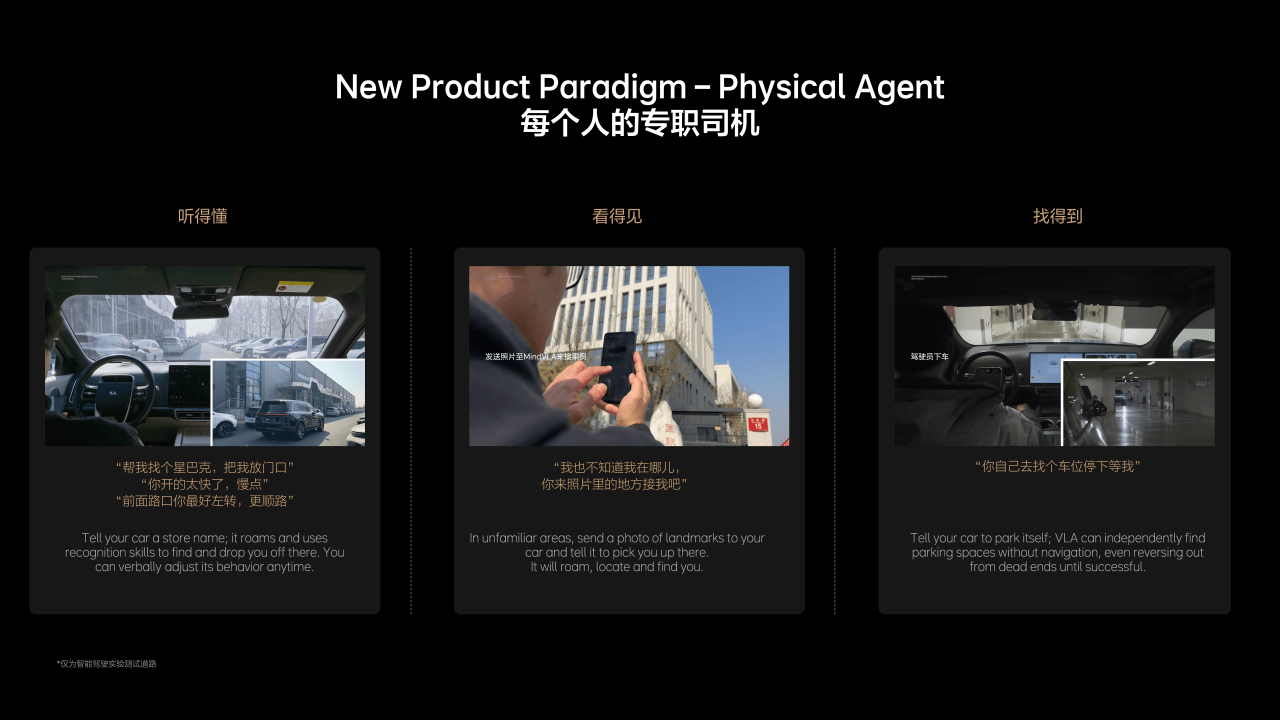

MindVLA的目標(biāo)很明確,就是讓車變成聽懂你話的好司機。它在三個場景表現(xiàn)尤為突出。首先是語音交互,當(dāng)你開車時,可以隨時給車下新指令,比如“開慢點”、“向左轉(zhuǎn)”等,車能馬上照做,這比以前車機只能關(guān)關(guān)空調(diào)、打開車窗要高級得多。

其次是視覺通識,你可以理解為給發(fā)張周圍環(huán)境的照片,它就能知道你在哪,然后自動過來接你,這功能相當(dāng)于省了個“專門司機”了,它之所以能做到,是因為MindVLA能理解招牌、地標(biāo)等視覺信息,甚至連施工圍擋后面的臨時路都能識別。

最后則是自動空間的探索,在停車場或園區(qū)里,車能自己到處找停車位,不用依賴導(dǎo)航,可能大家會說,其他車型也能自動找車位泊車,但你要注意的是,其他車型的泊車功能基本局限在熟悉的停車場。按理想董事長李想的話,你跟人司機咋交流,就能跟MindVLA咋交流,以后停車也不發(fā)愁。對比特斯拉FSD頻出誤判路標(biāo)路線,MindVLA通過本地化訓(xùn)練和邏輯推理,就能解決這些麻煩事。

顛覆傳統(tǒng)還是步子太大?

MindVLA一發(fā)布,相當(dāng)于給傳統(tǒng)自動駕駛技術(shù)路線來了個大挑戰(zhàn)。它打破對高精地圖的依賴,通過自研的模型,車能模擬環(huán)境自己學(xué)習(xí),也不用花大價錢去依賴地圖數(shù)據(jù)。

更關(guān)鍵是它似乎重新定義了人和車的關(guān)系,以前的智駕系統(tǒng)是聽你指令干活,但MindVLA能和你互動,你說應(yīng)該走右邊這條路,它不僅做,還能記住你的駕駛習(xí)慣,慢慢成為你生活中伙伴。

而且該技術(shù)還能向外擴展的潛力,能應(yīng)用到機器人等智能領(lǐng)域,這確實能為行業(yè)帶來一定性的啟發(fā)。不過,雖然能通過技術(shù)優(yōu)化不少問題,但城市里復(fù)雜路況的極端情況,還得時間去驗證。

汽車網(wǎng)評:

總的來說,MindVLA確實給自動駕駛帶來新的思路,要是真量產(chǎn)成功,那自動駕駛說不定就能實現(xiàn)質(zhì)的飛躍。但理想步子邁的那么大,能否成功還得看接下來實際表現(xiàn)如何。