微軟放大招,Phi-4專攻推理

4 月 30 日,微軟重磅發布了三款針對復雜推理任務優化的小型 AI 模型,統稱為“Phi-4 reasoning”系列。該系列基于微軟此前發布的 Phi-4 模型,通過監督微調并結合 o3-mini 提供的高質量推理訓練數據,強化了“教會 AI 如何思考”的能力。

這三款模型包括標準版 Phi-4-reasoning、強化學習升級版 Phi-4-reasoning-plus,以及輕量級版本 Phi-4-mini-reasoning,均為開源模型,覆蓋從高效執行到低資源場景的不同需求。

圖片信息來源于網絡

多步驟推理,AI也能“慢慢想”

Phi-4 reasoning 最大的亮點之一是引入了“推理時間擴展”(inference-time scaling)機制,允許模型在遇到復雜問題時“多想一步”,有效提升了多步驟、遞進式任務的表現,特別適用于數學、邏輯推理和智能代理場景。

在訓練過程中,這些模型借助 OpenAI o3-mini 提供的推理演示,學會了如何一步步拆解問題、形成有條理的“思維鏈條”,就像一個數學老師在黑板前寫步驟一樣,講得清清楚楚。

圖片信息來源于網絡

標準版 vs 加強版:性能再進化

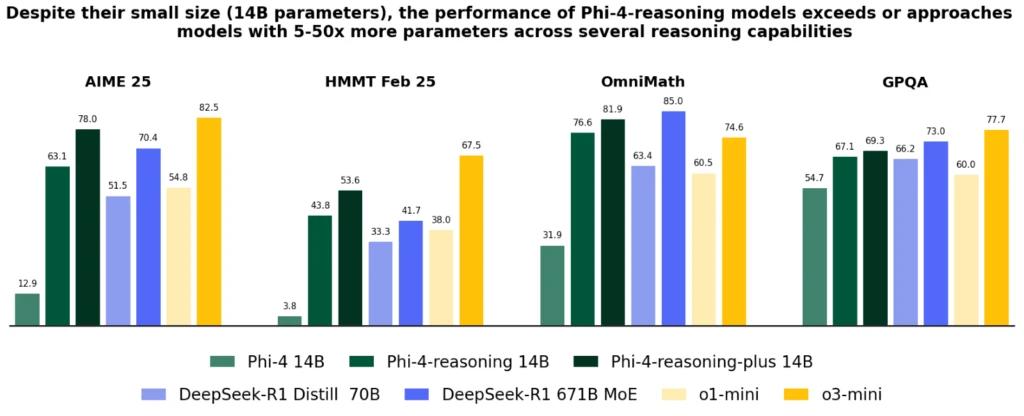

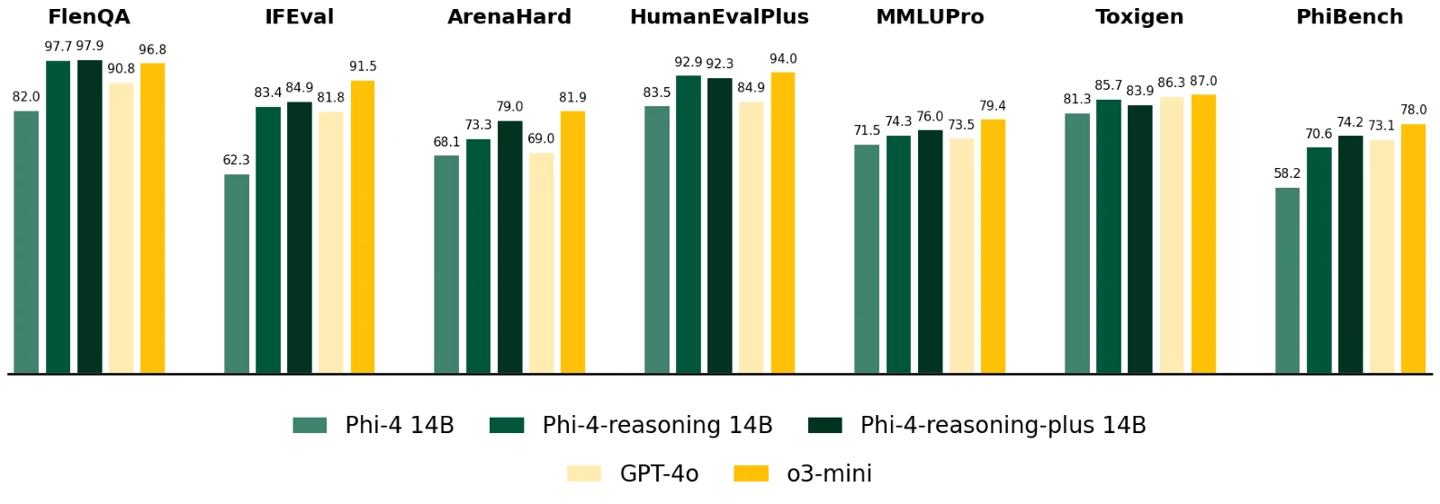

標準版 Phi-4-reasoning 擁有 140 億參數,已經在多個基準測試中超越了 OpenAI o1-mini 和

DeepSeek-R1-Distill-Llama-70B 等競品。而“加強版”Phi-4-reasoning-plus 則在此基礎上加入了強化學習訓練,token 消耗提升 1.5 倍,換來了更高的精準度和更強的泛化能力。

最驚艷的是,兩款模型在美國 AIME 奧數資格賽上表現居然優于 DeepSeek-R1 的 6710 億參數版本,打了個漂亮的“小模型逆襲大模型”的翻身仗。

圖片信息來源于網絡

mini 版發力邊緣場景,教育輔導新利器

針對算力緊張場景,微軟還推出了僅 3.8 億參數的 Phi-4-mini-reasoning,專為邊緣設備、教育應用等輕量部署而生。別看它小,模型專攻數學推理,在多個測試集上打敗了 OpenThinker-7B 和 Llama-3.2-3B-instruct,性能極具性價比。

這款模型還能覆蓋中學到博士級難度的百萬級問題庫,非常適合做題輔助、作業批改、線上輔導等應用場景,也為 AI 進入教育場景鋪平了道路。